Gdy myślisz o narzędziach SEO, pierwsze co przychodzi Ci do głowy to pewnie Google Search Console, Ahrefs, może Screaming Frog. Ale logi serwera? To raczej temat dla administratora strony, prawda? Tylko że to właśnie w niedocenianych logach znajdziesz pełny zapis tego, jak roboty wyszukiwarek naprawdę poruszają się po witrynie. W tym artykule pokażemy, jak sprawdzić logi serwera, jak je czytać i – co najważniejsze – jak wykorzystać je w działaniach SEO.

Czego dowiesz się z artykułu?

- Czym dokładnie są logi serwera i dlaczego SEO powinno się nimi interesować?

- Gdzie są logi serwera i jak uzyskać do nich dostęp?

- Jak czytać logi serwera? Przewodnik krok po kroku dla początkujących

- Jakie konkretne informacje SEO można wydobyć z analizy logów serwera?

- Jakie narzędzia ułatwiają analizę logów serwera?

- Podsumowanie

- Najczęściej zadawane pytania

Czym dokładnie są logi serwera i dlaczego SEO powinno się nimi interesować?

Zanim jednak przejdziemy do praktyki, wyjaśnijmy, czym są logi serwera.

Co to są logi serwera w prostych słowach?

Logi serwera są chronologicznym zapisem wszystkich zapytań, jakie trafiają na Twój serwer – od użytkowników i od botów – oraz odpowiedzi, jakie serwer zwraca.

Każdy wpis w logach zawiera informacje o tym, kto odwiedził Twoją stronę i kiedy, jakiego adresu URL dotyczyło zapytanie oraz z jakim skutkiem zakończyła się próba jego realizacji. Wejścia na podstrony, próby pobrania pliku; wszystkie pojawią się w logach.

Wyobraź sobie, że serwer Twojej strony prowadzi... dziennik pokładowy. Za każdym razem, gdy ktoś chce nawiązać kontakt z serwerem, on to odnotowuje. Równie dobrze możesz to porównać do hotelowej księgi gości albo „czarnej skrzynki” w pojazdach; to ostatnie porównanie jest nawet trafniejsze, bo do logów najczęściej zagląda się, gdy na stronie pojawiają się problemy techniczne i trzeba znaleźć ich przyczynę.

Dlaczego analityka logów serwera to absolutny przełom w SEO?

Ale powodów, dla których warto zaglądać do logów serwera jest więcej. Zwłaszcza dla SEOwców, bo logi są najbardziej „surowym” źródłem danych o stronie.

- Gdy chcesz przeanalizować aktywność botów wyszukiwarki, w Google Search Console nie dostaniesz wszystkich informacji, a raczej szacunki, choć bardzo dokładne. Logi serwera, jak powiedzieliśmy, rejestrują całą aktywność botów na stronie: jakie konkretnie crawlery (nie tylko google’owskie) na nią wchodzą i jak podróżują przez kolejne podstrony;

- Widzisz dokładnie, które podstrony są regularnie odwiedzane przez roboty indeksujące, a które są ignorowane. Możesz też zidentyfikować strony-pułapki, które niepotrzebnie pochłaniają budżet crawlowania Google;

- Logi serwera pozwalają namierzyć wszystkie błędy, jakie pojawiają się podczas crawlowania strony: 404 i 5xx, łańcuchy oraz pętle przekierowań.

Gdzie są logi serwera i jak uzyskać do nich dostęp?

Logi generowane i przechowywane są bezpośrednio na serwerze, z reguły w pliku tekstowym z rozszerzeniem .log. Dostęp do niego możesz zdobyć na dwa sposoby: albo przez panel klienta, który oferuje dostawca hostingu, albo przez protokół FTP.

Jak zlokalizować pliki z logami na popularnych hostingach?

Dokładne instrukcje, jak to zrobić, na pewno znajdziesz na stronie hostingodawcy. My pokażemy obie ścieżki.

Dostęp do logów tylko przez protokół FTP oferuje dziś większość popularnych polskich hostingów, na przykład home.pl, dhosting.pl czy LH.pl. W każdym przypadku wygląda to tak samo:

- Pobierz program do obsługi połączeń FTP (najprostsza będzie Filezilla, chociaż polecamy też np. Total Commandera).

- Nawiąż nowe połączenie z serwerem FTP – będziesz musiał wpisać nazwę serwera (np. serwer123.lh.pl), nazwę użytkownika/usługi (w tym przypadku będzie to serwer123) oraz swoje hasło do serwera.

- Gdy nawiążesz połączenie, pokaże Ci się lista plików i folderów na serwerze. W zależności od dostawcy logi będą znajdować się w katalogu /logs albo /access_log - i stamtąd możesz pobrać plik .log na swój komputer.

Nic trudnego – ale jeszcze prościej jest, gdy hostingodawca udostępnia logi przez panel klienta. Taką opcję oferuje np. nazwa.pl i OVHcloud. W takiej sytuacji:

- Wejdź na stronę panelu klienta (np. admin.nazwa.pl) i zaloguj się przy użyciu nazwy użytkownika oraz swojego hasła.

- Znajdź zakładkę z logami: a) w przypadku nazwa.pl ścieżka to Statystyki → Logi serwera → Access Log; b) zaś w przypadku OVH – Hosting → Statystyki i logi → Logi strony WWW.

- A następnie pobierz plik logów serwera z dnia, który Cię interesuje.

O co zapytać dostawcę hostingu, jeśli nie możesz znaleźć logów?

Jeśli nie masz bezpośredniego dostępu do plików serwera, a hostingodawca nie udostępnia panelu klienta – a tak może być na serwerach współdzielonych – skontaktuj się z supportem hostingu i poproś o kopię logów. Dostawcy raczej są gotowi na takie pytania. ;)

Poniżej szablon krótkiego maila z taką prośbą:

Dzień dobry,

Piszę z prośbą o udostępnienie logów serwera (access logs) dla domeny [TwojaDomena.pl], obsługiwanej w ramach konta klienta [nazwa konta lub ID klienta]. ← podaj jak najwięcej danych, które potwierdzą, że masz uprawnienia dostępu do serwera!

Chciałbym uzyskać pliki logów z dnia [data] zawierające zapisy zapytań HTTP, informacje o User-Agent oraz znaczniki czasowe. Logi będą wykorzystane wyłącznie do celów analizy SEO.

Dziękuję za pomoc i czekam na odpowiedź.

Pozdrawiam serdecznie,

[Twoje imię i nazwisko]

[Twoja firma / dział, jeśli dotyczy]

Czy istnieją alternatywne metody śledzenia aktywności botów?

Jeśli z jakiegoś powodu nie masz dostępu do logów serwera, istnieją też inne sposoby monitorowania ruchu botów, choć żaden nie da Ci tak pełnych danych, jak analiza logów.

- Google Search Console i raport „Statystyki indeksowania" (Crawl Stats) – znajdziesz tam informacje, ile zapytań do serwera Googlebot wykonał w danym okresie i jak szybko ładował Twoją stronę. Nie dostaniesz jednak listy konkretnych URLi;

- Cloudflare Analytics – jeśli strona korzysta z Cloudflare, możesz włączyć funkcję rejestrowania aktywności crawlerów w zakładce „Bot Analytics”. To nie są klasyczne logi serwera, ale dane oparte na analizie ruchu na poziomie DNS; nie tak dokładne, ale i tak wartościowe;

- pluginy typu Bot Logger – większość CMSów ma w swoich bibliotekach wtyczki, które rejestrują wizyty robotów bezpośrednio na poziomie CMSa. Nie jest to rozwiązanie idealne, bo nie obejmie całego ruchu, ale jest jakąś alternatywą.

Jak czytać logi serwera? Przewodnik krok po kroku dla początkujących

Załóżmy, że masz już dostęp do logów. Gdy wejdziesz w plik .log, zobaczysz całą ścianę tekstu przypominającą z daleka kod z Matrixa. Ale to tylko pierwsze wrażenie, bo tak naprawdę wpisy w logach mają bardzo schematyczną i prostą strukturę.

Z jakich elementów składa się typowy wpis w logu?

Tak więc wygląda przykładowy wpis:

Rozbijmy go na części pierwsze.

| Element | Przykład | Wyjaśnienie |

|---|---|---|

| Adres IP | 66.249.66.1 | Identyfikuje, kto wykonał zapytanie. W tym przypadku jest to jedno z wielu IP należących do Googlebotów. |

| Znacznik czasu | [30/Jul/2025:10:14:05 +0200] | Dokładny czas, kiedy żądanie dotarło do serwera (+0200 oznacza strefę czasową). |

| Żądanie HTTP | "GET /blog/jak-analizowac-logi-serwera/ HTTP/1.1" | Zapytanie, które przeglądarka wysłała do serwera. Mamy tu metodę przesyłu danych (GET/POST), ścieżkę URL żądanego zasobu oraz obsługiwaną wersję HTTP. |

| Status HTTP | 200 | Kod odpowiedzi serwera 200 oznacza, że strona została poprawnie załadowana. |

| Wielkość przesłanego pliku | 5234 | Wyrażana w bajtach (w tym przypadku jest to ponad 5 kB). |

| Adres referencyjny | “-” | W tym miejscu pojawia się adres strony, z której przyszedł użytkownik; może być pusty. |

| User-Agent | "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" | Identyfikuje przeglądarkę i/lub robota. |

Jak odfiltrować ruch i zidentyfikować boty wyszukiwarek?

Jeśli chcesz na poważnie filtrować i analizować logi, raczej nie radzimy robić tego ręcznie – tylko się sfrustrujesz, bo wpisów każdego dnia mogą być dziesiątki tysięcy. ;) O narzędziach, z których warto korzystać, powiemy niżej.

Natomiast jeżeli chcesz po prostu zidentyfikować wyłącznie wizyty botów wyszukiwarek na stronie, szukaj User-Agents z atrybutami „Googlebot”, „Bingbot” czy „DuckDuckBot”.

Jakie konkretne informacje SEO można wydobyć z analizy logów serwera?

Pora przejść do praktyki. Jak wspomnieliśmy na samym początku, analiza logów pod kątem SEO powinna dać Ci odpowiedzi na kilka ważnych pytań.

- Czy i jak często roboty indeksujące odwiedzają ważne podstrony?

- Czy nie marnują crawl budget na te mniej istotne?

- Czy napotykają błędy techniczne?

Jak zoptymalizować budżet crawlowania (crawl budget)?

Twoim celem powinno być to, aby roboty indeksujące regularnie odwiedzały najważniejsze URLe, a unikały:

- stron z parametrami sortowania (?sort=price);

- filtrów produktów;

- paginacji z bardzo wysokimi numerami;

- treści archiwalnych.

To typowe pułapki, które potrafią wciągnąć bota w strony bez większej wartości SEO i tylko marnować crawl budget. A w efekcie – blokować indeksowanie naprawdę ważnych adresów, zwłaszcza na rozbudowanych stronach i w sklepach, gdzie takich zasadzek jest najwięcej.

Co zrobić? Analizuj logi i szukaj anomalii. Potem możesz je zablokować w robots.txt albo, być może, ograniczyć zbędne linki wewnętrzne, tak żeby struktura strony prowadziła boty do tych ważnych podstron.

Jakie błędy techniczne i problemy z indeksacją wykrywają logi?

Logi serwera dostarczają sporo informacji czysto technicznych; ważnych, jeśli chcesz wiedzieć, co utrudnia botom indeksowanie Twojej strony. Analizując logi możesz bardzo łatwo znaleźć:

- błędy 404 – w logach serwera znajdziesz wszystkie niedziałające linki wewnętrzne, które „widzi" Googlebot. Może to być efekt błędów w linkowaniu wewnętrznym, nieaktualnych URLi lub stron, które zostały usunięte bez ustawienia poprawnych przekierowań;

- błędy serwera 5xx – jeśli bot napotyka błędy 500, 502 czy 503, oznacza to problemy z dostępnością Twojej strony (np. przeciążenie serwera lub błędy konfiguracji Apache/Nginx);

- zbyt długie czasy odpowiedzi serwera – logi zawierają często informacje o czasie potrzebnym na obsłużenie żądania (response time). Jeśli Googlebot regularnie otrzymuje odpowiedzi z dużym opóźnieniem (np. powyżej 500-1000 ms), może to sygnalizować problemy z wydajnością serwera.

Jak zweryfikować, czy kluczowe strony są regularnie odwiedzane przez Google?

Witryna może mieć setki, tysiące podstron – ale nie wszystkie są równie istotne. Masz sprzedażowe landing page’e, wpisy blogowe, kategorie produktowe? To właśnie te URLe regularnie powinien odwiedzać Googlebot. A nie zawsze tak jest.

A zatem:

1. Stwórz listę priorytetowych URLi. Zbierz wszystkie podstrony, które są kluczowe dla strategii SEO (np. strony generujące największy ruch organiczny, najważniejsze wpisy blogowe, kategorie produktowe).

2. Zawęź logi tylko do zapytań wysyłanych przez Googleboty.

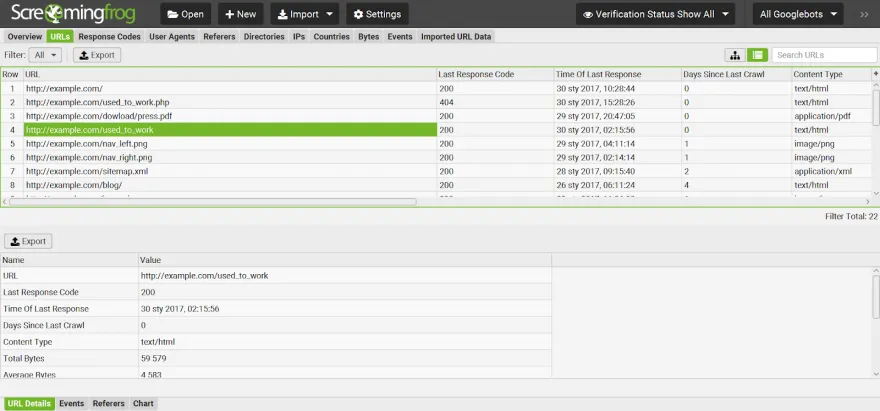

3. Przeszukaj logi pod kątem wybranych przez Ciebie adresów i zwróć uwagę na częstotliwość wizyt – w Screaming Frog możesz jednym kliknięciem posortować wszystkie URLe wg ilości wizyt. Jeśli istotna dla SEO podstrona była odwiedzana przez Googlebota do dwóch tygodni wcześniej – wszystko jest w porządku. Ale jeśli nie było jej w logach od miesiąca – to już może być sygnał alarmowy.

4. Sprawdź przy okazji, czy boty szybko odkrywają nowe podstrony – gdy dodajesz np. nowy wpis blogowy, logi serwera pokażą Ci, kiedy Googlebot pierwszy raz na niego trafił. To świetny sposób, żeby sprawdzić, czy linkowanie wewnętrzne na stronie oraz sitemap działają, jak należy.

Jakie narzędzia ułatwiają analizę logów serwera?

W teorii możesz analizować logi w pliku tekstowym albo przeformatować je do Excela – nic nie stoi na przeszkodzie. Ale tak jak mówimy: zajmie Ci to całe dni i prawdopodobnie nie wyłapiesz wszystkich istotnych zdarzeń.

Lepiej sięgnąć po gotowe narzędzia:

- Screaming Frog Log File Analyser – chyba najpopularniejsze narzędzie stricte dla SEOwców, które pozwala bardzo szybko i sprawnie przeanalizować logi. Wpisy są już domyślnie filtrowane wg głównych kategorii, Screaming Frog sam wygeneruje też wykresy ze statystykami, więc ręcznej pracy jest naprawdę mało. Cena to 130 euro za rok; w darmowej wersji można przeanalizować do 1000 wpisów w jednym pliku;

- Semrush Log File Analyzer – jeśli na co dzień pracujesz z Semrushem, gotowe narzędzie masz pod ręką; świetnie sprawdza się jako uzupełnienie audytów technicznych na platformie (np. Site Audit) – można łatwo zestawić dane z crawla i logów;

- OnCrawl Log Analyser – kolejne narzędzie „pod SEO”, które pozwala skonfigurować automatyczne raporty dotyczące błędów 404, łańcuchów przekierowań czy nieefektywnego wykorzystania crawl budgetu. Droższe, ale godne polecenia.

Są też inne aplikacje klasy enterprise pokroju ELK Stack czy Botify Log Analyzer, ale w przypadku większości stron w zupełności wystarczy Ci Screaming Frog.

Podsumowanie

Logi serwera są świetnym źródłem danych nie tylko dla administratorów, ale też dla specjalistów SEO. Jeśli chcesz wiedzieć, jak naprawdę Googlebot porusza się po Twojej stronie: co indeksuje, co ignoruje, a gdzie napotyka problemy techniczne – ich analiza powinna na stałe stać się częścią Twoich audytów. Powodzenia!

Najczęściej zadawane pytania

Czy analiza logów serwera jest bezpieczna dla mojej strony?

Tak, analiza logów serwera jest całkowicie bezpieczna – przeglądasz jedynie zapisy tego, co już się wydarzyło. Nie ingerujesz w pliki strony ani w konfigurację serwera.

Czym różnią się dane z logów od danych w Google Analytics?

Jak często powinienem analizować logi serwera?

Źródła:

https://pomoc.home.pl/baza-wiedzy/jak-sprawdzic-logi-wwwhttp-dla-mojego-serwera

https://www.semrush.com/blog/log-file-analysis/

Zapisz się do darmowego newslettera

Zyskaj dodatkową wiedzę o SEO, marketingu i technologiach.