Dobra komunikacja to klucz do udanej współpracy; tak jest w każdej firmie, w każdym zespole… i w pracy z modelami językowymi. W tym wpisie opowiemy o trzech praktycznych technikach pisania promptów: nadawaniu person, metodzie chain-of-thought oraz few-shot prompting, które dadzą Ci o wiele większą kontrolę nad tym, jakich odpowiedzi udziela AI – i które możesz bardzo łatwo zastosować w pracy.

Czego dowiesz się z artykułu?

- Dlaczego Twoje prompty nie działają? Różnica między rozmową a inżynierią

- Filar 1: metoda persona – nadaj kontekst i perspektywę

- Filar 2: Chain-of-Thought (CoT) – zmuś AI do myślenia

- Filar 3: Few-Shot Prompting – nauka na przykładach

- Synergia: jak połączyć te techniki w jeden „super-prompt”?

- Prompt engineering to nowa waluta w marketingu

Dlaczego Twoje prompty nie działają? Różnica między rozmową a inżynierią

Wyobraź sobie, że zatrudniasz copywritera, aby napisał tekst na landing page promujący flagowy produkt Twojej firmy. Czy powiesz mu po prostu „napisz coś o naszym produkcie"?

Jeśli liczysz na to, że efekt będzie można umieścić z czystym sumieniem na stronie – raczej nie. ;) W tym miejscu każdy, nawet najlepszy specjalista, który pracował nad kampaniami dla kilkunastu podobnych marek, będzie potrzebował briefu z informacjami:

- dla kogo piszemy,

- w jakim tonie,

- jaki jest cel tekstu,

- jakie są cechy produktu,

- jakie problemy klientów ma on rozwiązywać oraz jakie jest jego UVP,

- jaką mamy konkurencję…

Z AI jest dokładnie tak samo. Aby model językowy wygenerował odpowiedź, która faktycznie ma jakąś wartość, potrzebuje jak najwięcej kontekstu. Jeśli go nie dostanie, będzie musiał sam wywnioskować i dopowiedzieć sobie wszystkie informacje niezbędne do wykonania zadania, opierając się na swoim wytrenowanym zbiorze „wiedzy”. Problem polega na tym, że w takiej sytuacji nie masz praktycznie żadnej kontroli nad tym, co model wygeneruje.

Na szczęście wszystkie LLMy są, w bardzo dużym skrócie, modelami matematycznymi i mają swoje schematy działania. A prompt engineering daje konkretne techniki, jak te schematy wykorzystać. Poniżej powiemy o trzech z nich.

Filar 1: metoda persona – nadaj kontekst i perspektywę

Zacznijmy od najprostszej. Metoda persona polega na tym, aby na początku rozmowy z modelem określić wprost rolę, jaką ma przyjąć. To znaczy: mówisz modelowi, kim ma być, gdy Ci odpowiada – czy ma pisać i rozumować jak content marketer, coach, czy doświadczony programista prowadzący kurs z Pythona. Bardzo prosta rzecz, a potrafi zupełnie zmienić styl odpowiedzi generowanych przez AI.

Porównajmy dwa prompty:

1. Napisz post na LinkedIn (na maks. 200 słów) o tym, dlaczego programiści powinni budować swój personal brand w sieci, nawet jeśli nie planują zmiany pracy.

2. Jesteś ekspertką od personal brandingu z 12-letnim doświadczeniem w pracy ze specjalistami IT. Twoje posty na LinkedIn zawsze zaczynają się od osobistej historii lub prowokacyjnego pytania, używasz storytellingu i kończysz konkretnym call-to-action. Napisz post (na maks. 200 słów) o tym, dlaczego programiści powinni budować swój personal brand w sieci, nawet jeśli nie planują zmiany pracy.

Jakie odpowiedzi wygeneruje na ich podstawie AI? Skorzystaliśmy z pomocy Claude Sonnet 4.5.

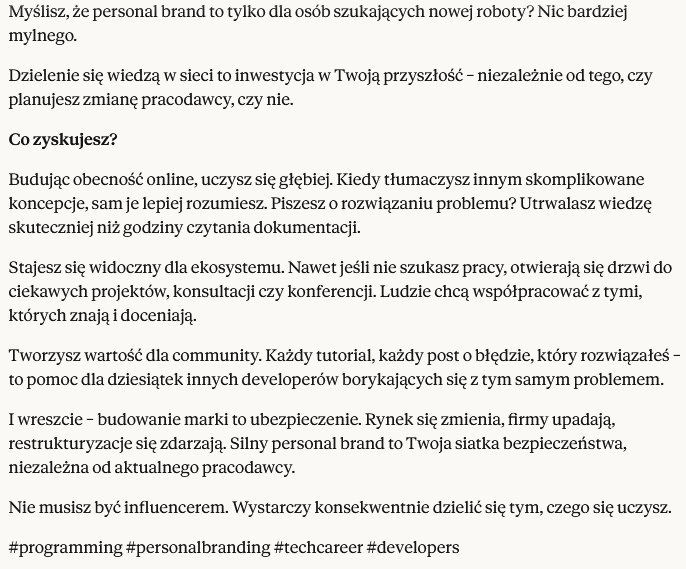

Tak wyglądała odpowiedź na pierwszy prompt:

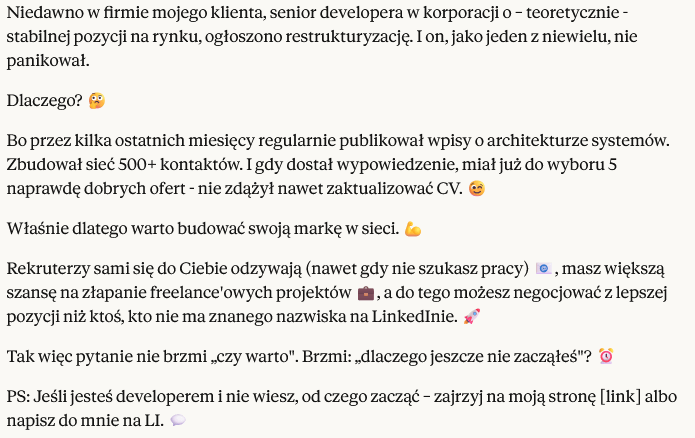

Brzmi... nijako, prawda? Drugi prompt dał zupełnie inny efekt:

Tutaj mamy już o wiele bardziej charakterystyczny styl, typowy dla publikacji na LinkedInie. Nadal nie jest to idealny tekst; dobrze byłoby go rozwinąć i przeredagować, ale z pewnością będzie lepszym punktem wyjścia do dalszej pracy.

Mechanika: jak zawężenie roli wpływa na zasoby wiedzy AI?

Warto zrozumieć, że modele językowe „nie wiedzą" rzeczy; działanie generatywnych modeli AI opiera się na wzorcach statystycznych, które zostały przez nie wypracowane na podstawie zbioru danych treningowych. A te obejmują miliardy tekstów z różnych dziedzin: literatury, medycyny, prawa, marketingu, programowania... dosłownie wszystkiego.

Dopóki nie określisz persony, model będzie czerpał z całej tej ogromnej puli danych i próbował wygenerować taką treść, która będzie pasowała do jak największej liczby kontekstów. Ale gdy narzucisz AI konkretną rolę – model „uruchomi” te wzorce językowe i struktury wiedzy, które są dla niej charakterystyczne. W tym cały sekret.

Filar 2: Chain-of-Thought (CoT) – zmuś AI do myślenia

Drugą techniką jest chain-of-thought. Polega to na zmuszeniu modelu do rozłożenia problemu na kroki i przemyślenia każdego z nich przed udzieleniem odpowiedzi. Czyli, zamiast pytać „Jaki jest wynik?", pytasz „Jaki jest wynik i jak dojść do niego krok po kroku?".

Magia frazy „Let's think step by step"

Na przełomie 2022 i 2023 roku naukowcy z Japonii przeprowadzili ciekawe badanie, opisane później w artykule Large Language Models are Zero-Shot Reasoners. Porównali, jak radziły sobie największe LLMy z rozwiązywaniem złożonych problemów wymagających logicznego rozumowania.

Co się okazało: dodanie do promptu tylko jednego zdania, Let's think step by step, aż kilkukrotnie ograniczało halucynacje AI – na przykład w zadaniach arytmetycznych precyzja odpowiedzi wzrastała z 17,7 do 78,7 procent. Jak to można wyjaśnić? Fraza ta sygnalizuje modelowi, że ma wygenerować całą „ścieżkę rozumowania", zanim poda odpowiedź. Model wypisuje więc kolejne kroki, przechodzi przez nie – i, co najważniejsze, w trakcie tego procesu koryguje sam siebie, jeśli któryś z kroków nie pasuje logicznie do poprzedniego. W podobny sposób zadziałają polecenia typu „Rozłóż ten problem na etapy i przeanalizuj każdy z nich" albo „Zanim odpowiesz, wypisz wszystkie kroki, które musisz wykonać".

Oczywiście, możesz też przygotować prompt, w którym sam wypiszesz, przez jakie kroki ma przejść model – wtedy nie dość, że zmusisz AI do głębszego rozumowania, to jeszcze zyskasz większą kontrolę nad całym procesem.

Praktyka: planowanie kampanii marketingowej z CoT

Jak to może zadziałać w praktyce? Porównajmy znów dwa prompty.

1. Mam 15 000 zł budżetu miesięcznego na reklamę sklepu z ekologicznymi kosmetykami. Średnia wartość zamówienia to 180 zł, cel to 80 zamówień miesięcznie. Pomóż mi zdecydować, jak podzielić budżet między Facebook Ads a Google Ads.

2. Mam 15 000 zł budżetu miesięcznego na reklamę sklepu z ekologicznymi kosmetykami. Średnia wartość zamówienia to 180 zł, cel to 80 zamówień miesięcznie. Pomóż mi zdecydować, jak podzielić budżet między Facebook Ads a Google Ads. Pomyśl krok po kroku.

Z pierwszym Claude poradził sobie tak:

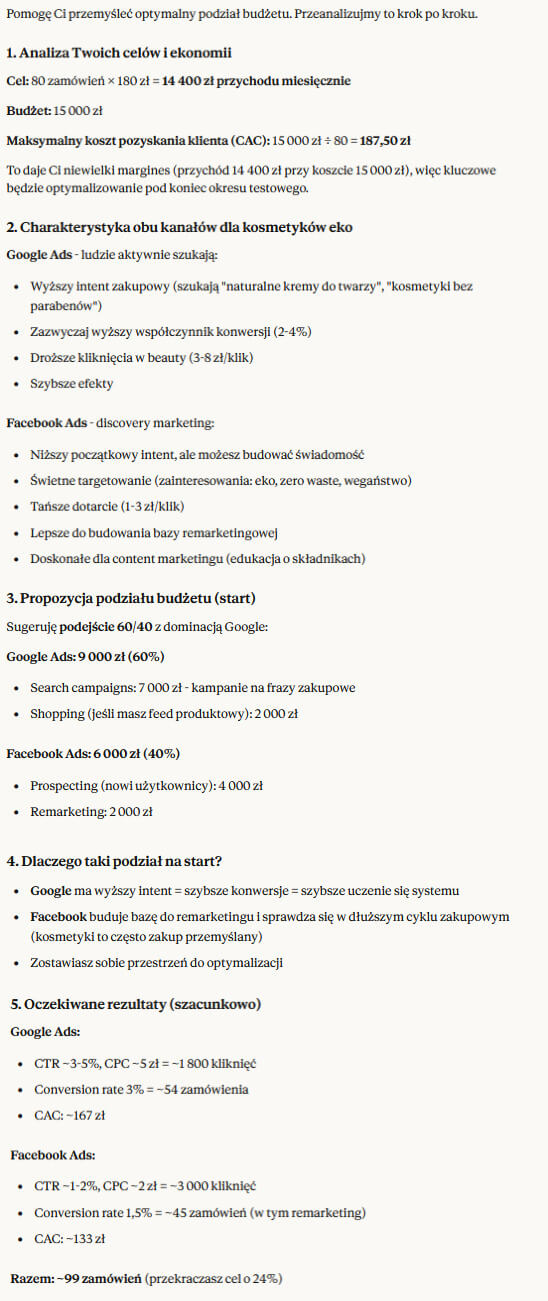

Z drugim zaś, tak:

Na drugą analizę trzeba było poczekać kilkanaście sekund dłużej… ale na pewno jest bardziej rozwinięta. Widać też w niej wyraźnie, jaka była ścieżka wnioskowania modelu, plus, jeśli chciałbyś dalej pracować nad tą strategią, możesz łatwo odwoływać się do konkretnych pomysłów wygenerowanych przez model w tej samej konwersacji.

Filar 3: Few-Shot Prompting – nauka na przykładach

Jeśli persony określają, w jaką rolę ma wcielić się AI, a chain-of-thought – w jaki sposób ma myśleć, to trzecia technika pozwala zdefiniować, jak ma wyglądać output.

Na tym właśnie polega few-shot prompting – dołączasz do promptu kilka (najczęściej 3-5) przykładów wzorcowych odpowiedzi na podobne pytania, a model „wyłapuje” schemat i według niego generuje odpowiedź na Twoje zadanie. Może to wyglądać tak:

Twoim zadaniem jest tworzenie krótkich, chwytliwych tagline'ów dla marek. Oto kilka przykładów:

Marka: Nike

Tagline: Just Do It.

Marka: Apple

Tagline: Think Different.

Marka: L'Oréal

Tagline: Because You're Worth It.

Teraz stwórz propozycję tagline’u dla marki ekologicznych kosmetyków o nazwie „Pure Earth", która kieruje swoją ofertę do świadomych konsumentów ceniących naturę.

Odpowiedź wygenerowana przez Claude brzmi: Nature's Beauty, Honestly Yours. Proste, uniwersalne hasło, z bardzo bezpośrednim zwrotem do odbiorcy marki – podobnie jak w podanych przykładach.

Zero-Shot vs Few-Shot – dlaczego kontekst to król

Few-shot prompting przypomina nieco to, jak często wygląda praca np. z grafikami. Jeśli, powiedzmy, chcesz stworzyć nowe logo dla swojej marki i masz w głowie pewną wizję, możesz mu spróbować ją opisać – albo znaleźć przykłady grafik w bardzo podobnym stylu i powiedzieć „to jest nasz kierunek”. Ten drugi scenariusz z reguły kończy się lepiej. Dlaczego? Ponieważ daje on każdemu – i zlecającemu, i twórcy – bardzo konkretne punkty odniesienia do pracy. Few-shot prompting wykorzystuje przy tym fakt, że modele generatywne bardzo dobrze radzą sobie z identyfikowaniem wzorców. Wystarczy więc tylko kilka przykładów, a model powinien od razu zrozumieć, jakiego tonu, struktury, stylu od niego oczekujesz.

Przeciwieństwem tej techniki jest zero-shot prompting, czyli promptowanie bez żadnych „inspiracji” dla modelu. Wówczas AI bazuje wyłącznie na schematach nabytych w trakcie treningu… nad czym, jak wspomnieliśmy na samym początku, nie masz żadnej kontroli.

Szablon Few-Shot do generowania lead magnetów

Poniżej jeszcze jeden, nieco bardziej praktyczny przykład, jak można wykorzystać tę technikę.

Powiedzmy, że prowadzisz małą agencję zajmującą się prowadzeniem social media dla firm. Aby zdobyć nowych klientów, chcesz opublikować darmowy poradnik w formie e-booka, który zadziała jak lead magnet – da potencjalnym odbiorcom konkretną wartość w zamian za ich adresy mailowe.

W poszukiwaniu inspiracji możesz wysłać AI prompt w stylu:

Twoim zadaniem jest generowanie tytułów lead magnetów (e-booków), które jasno komunikują korzyść i są sformułowane w stylu, który wzbudza ciekawość odbiorcy.

Przykłady:

Branża: Finanse osobiste

Lead magnet: „5 błędów finansowych, które kosztują Cię tysiące złotych rocznie (i jak ich uniknąć)"

Branża: E-commerce

Lead magnet: „Checklista: 27 rzeczy, którymi musisz się zająć, zanim uruchomisz swój e-sklep"

Branża: HR

Lead magnet: „Kompletny przewodnik: jak poprowadzić rekrutację, która przyciągnie najlepszych kandydatów" Teraz wygeneruj tytuł e-booka, który opublikuje agencja social media – grupą docelową są małe firmy, które dopiero zakładają swoje profile w mediach społecznościowych.

Na podstawie tego prompta Claude wygenerował dwa przykłady:

„Social media od zera: 30-dniowy plan działania dla małej firmy (bez marnowania budżetu na reklamy!)"

„Pierwsze 90 dni w social mediach: co publikować, kiedy i jak często, żeby zbudować społeczność wokół swojej marki"

Oba jak najbardziej wpisują się w styl z przykładów: mamy liczby, jasno przedstawioną korzyść dla klienta i nawiązanie do problemu grupy docelowej.

Jaki z tego wniosek? Wcale nie jest trudno pokierować modelem AI, aby pracował tak, jak tego oczekujesz. Wystarczy umiejętnie wplatać dodatkowy kontekst w prompty. Podsumujmy więc, co konkretnie możesz osiągnąć, stosując każdą z przedstawionych dzisiaj technik.

| Technika | Kiedy stosować? |

|---|---|

| Persona | Gdy potrzebujesz odpowiedzi w określonym stylu/tonie lub chcesz, aby model odwoływał się do konkretnej gałęzi wiedzy, jak ekspert. |

| Chain-of-Thought Prompting | Gdy zadanie wymaga logicznego rozumowania, obliczeń, planowania lub bardziej złożonych analiz. |

| Few-Shot Prompting | Gdy chcesz, aby model naśladował określony format, styl lub strukturę odpowiedzi. |

Synergia: jak połączyć te techniki w jeden „super-prompt”?

Oczywiście techniki te bez problemu można połączyć w jednym promptcie. Mógłby on wyglądać na przykład tak:

Jesteś doświadczonym email marketerem specjalizującym się w e-commerce. Twoje kampanie osiągają średni open rate 35% i CTR na poziomie 8%, bo zawsze piszesz subject liny, które budzą ciekawość i tworzysz treści mailingów skupione na bardzo konkretnej korzyści dla odbiorcy.

Oto przykłady Twoich subject line’ów:

- „Tylko dziś: 30% rabatu znika o północy (sprawdź, zanim będzie za późno)"

- „Zapomniałeś czegoś w koszyku... dorzuciliśmy prezent 🎁"

- „Twoi znajomi już to mają. A Ty?"

Teraz opracuj plan kampanii mailingowej dla sklepu sportowego, który wprowadza nową linię odzieży treningowej z technologią termoaktywną. Pomyśl krok po kroku:

- Stwórz 5 wariantów subject line’ów do testów A/B.

- Napisz treść maila (max 150 słów) z wyraźnym CTA.

- Zaproponuj strategię follow-up dla osób, które nie otworzyły pierwszego maila.

Od razu widać, jak wszystkie trzy techniki się uzupełniają:

- persona nadaje styl i zawęża modelowi pole analizy do wybranego obszaru wiedzy;

- przykłady w duchu few-shot doprecyzowują styl odpowiedzi;

- zaś chain-of-thought rozbija zadanie na kilka etapów, zmuszając tym samym AI do głębszej analizy… a do tego pozwala sprecyzować, jakie mają być rezultaty pracy modelu.

Prompt engineering to nowa waluta w marketingu

Inżynierii promptów nauczyć się może każdy. Dobrze, jeśli wiesz, jak – mniej więcej – działają sieci neuronowe albo czym są tokeny, ale żeby być w stanie wygenerować naprawdę przyzwoity tekst z pomocą LLMów, wystarczy, że potrafisz z nimi rozmawiać. Tak więc następnym razem, gdy będziesz korzystać z pomocy AI w pracy, wypróbuj technik, które poznałeś w tym tekście – dziś jest to tak samo ważna umiejętność, jak znajomość Google Analytics albo WordPressa.

Pozostałe źródła:

https://www.promptingguide.ai/

https://platform.openai.com/docs/guides/prompt-engineering

https://www.ibm.com/think/topics/prompt-engineering-techniques

Zapisz się do darmowego newslettera

Zyskaj dodatkową wiedzę o SEO, marketingu i technologiach.