Korzystasz na co dzień z narzędzi AI, ale nie wiesz do końca, jak – tak naprawdę – działają? Sieci neuronowe, machine learning i fine tuning brzmią dla Ciebie jak hasła, które zrozumieją tylko inżynierzy? Jeśli tak – sprawdź nasz słownik sztucznej inteligencji dla początkujących.

Czego dowiesz się z artykułu?

- Dlaczego warto poznać te pojęcia?

- Podstawowe pojęcia

- Modele językowe i mechanizmy działania

- Dostosowywanie modeli i sterowanie wyjściami

- Rozszerzanie modeli o wiedzę – RAG i hybrydy

- Pozostałe pojęcia warte uwagi

- Zastosowania w marketingu, contentcie i automatyzacji

- Porównawcza tabela pojęć

- Ciekawostki i trendy

Dlaczego warto poznać te pojęcia?

Narzędzia AI pozwalają zrobić bardzo wiele w bardzo krótkim czasie… ale nie wszystko. To wciąż „tylko” narzędzia, które mają swoje zasady i ograniczenia. Jeżeli chcesz z nich korzystać przy tworzeniu treści, musisz je znać, bo bez tej wiedzy naprawdę łatwo jest przecenić ich możliwości. Albo wręcz przeciwnie – nie wykorzystać ich potencjału.

W naszym przewodniku wyjaśnimy najważniejsze pojęcia wokół sztucznej inteligencji i pokażemy, jak wykorzystać tę wiedzę, aby wdrażać narzędzia AI w przemyślany sposób, a nie tylko iść za trendami.

Podstawowe pojęcia

-

AI/sztuczna inteligencja

Sztuczna inteligencja to bardzo ogólny termin, opisujący wszystkie systemy, które potrafią wykonywać zadania wymagające ludzkich zdolności poznawczych – takie jak uczenie się, rozumienie języka naturalnego, rozpoznawanie obiektów i wzorców, planowanie działań czy podejmowanie decyzji.

Pod pojęciem sztucznej inteligencji kryje się cały zbiór technologii, które pozwalają maszynom przetwarzać informacje w „ludzki” sposób. Nie chodzi tylko o ChatGPT czy Midjourney – modele generatywne to tylko wierzchołek góry lodowej.

-

ML (uczenie maszynowe)

Machine learning jest jedną z najważniejszych – o ile nie najważniejszą – techniką wykorzystywaną do rozwoju AI. W dużym skrócie: to proces, w którym system komputerowy uczy się na podstawie dostarczanych mu danych i ulepsza swoje działanie bez programowania go „z zewnątrz”. System analizuje duży zbiór danych, szuka w nich wzorców i na tej podstawie sam tworzy reguły statystyczne, według których może przewidywać kolejne informacje albo podejmować decyzje w sytuacji braku danych.

Można wyróżnić wiele metod uczenia maszynowego, ale dla nas najważniejsze są dwie:

- Uczenie nadzorowane (supervised learning) – w którym model otrzymuje zestaw danych z opisanymi przez człowieka prawidłowymi odpowiedziami i uczy się na ich podstawie.

- Uczenie nienadzorowane (unsupervised learning) – w którym z kolei system dostaje „czyste” dane i samodzielnie próbuje odkryć wzorce, np. grupując podobne elementy albo rozpoznając często powtarzające się kombinacje słów.

Większość zastosowań AI – na przykład modele językowe – rozwija się przez kombinację tych metod.

-

Sieci neuronowe (neural networks)

Sieć neuronowa to system obliczeniowy inspirowany budową ludzkiego mózgu. Składa się z wielu warstw „neuronów” – prostych jednostek obliczeniowych, które przetwarzają dane, klasyfikują je i przekazują dalej. Każda warstwa sieci odpowiada za coraz bardziej złożone reprezentacje informacji. Na pierwszych poziomach model rozpoznaje proste wzorce (kształty, dźwięki, pojedyncze słowa), a na kolejnych – coraz bardziej abstrakcyjne koncepcje, na przykład całe struktury gramatyczne.

-

Transformer – architektura, która zmieniła NLP

Transformer to konkretny typ architektury sieci neuronowych, zaprezentowany w 2017 roku przez zespół badaczy z Google w pracy „Attention Is All You Need”. W ciągu 2-3 lat stał się podstawą w zasadzie wszystkich modeli zdolnych do przetwarzania języka naturalnego (NLP).

Tradycyjne modele – na przykład ten, który przez długie lata zasilał Tłumacza Google – przetwarzały tekst krok po kroku, słowo po słowie. Transformer działa inaczej i nie zamienia na liczby pojedynczych słów… tylko od razu całe zdania. Do tego ma wbudowaną warstwę uwagi – attention – która analizuje zależności między częściami zdania wejściowego i określa, które słowa są najważniejsze dla zrozumienia znaczenia reszty. Więcej o tym mechanizmie za moment.

-

Tokenizacja

Tokenizacja to dzielenie tekstu na mniejsze jednostki zwane tokenami. Token może być słowem, sylabą, liczbą, znakiem interpunkcyjnym czy też pojedynczą literą – wszystko zależy od tego, jak zaprojektowano dany model, a nawet w jakim języku napisano tekst.

Musisz pamiętać, że modele AI tak naprawdę nie operują na literach ani słowach, tylko na ich liczbowych reprezentacjach. Tokeny są jednostkami tekstu – najmniejszą porcją informacji, jaką „widzi” i przetwarza model.

Modele językowe i mechanizmy działania

Gdy używasz terminu „AI”, prawie na pewno myślisz o ChatGPT albo o innych modelach językowych. Dobrze byłoby więc wiedzieć, co to jest LLM od bardziej technicznej strony.

LLM (Large Language Model) – co to znaczy?

LLM, czyli Large Language Model, to model językowy wytrenowany na ogromnych zbiorach danych tekstowych: książkach, artykułach, stronach internetowych, transkrypcjach rozmów. Podczas treningu uczy się statystycznych zależności między słowami i potrafi przewidywać, jakie słowo najprawdopodobniej pojawi się jako następne w danym kontekście.

Technicznie LLMy od innych modeli generatywnych różnią się tym, że mają o wiele większą liczbę parametrów, czyli wag statystycznych, które system wypracowuje w procesie uczenia maszynowego. Im ich więcej, tym lepiej (przynajmniej w teorii). Dzięki temu model powinien być w stanie zrozumieć złożoność danego języka.

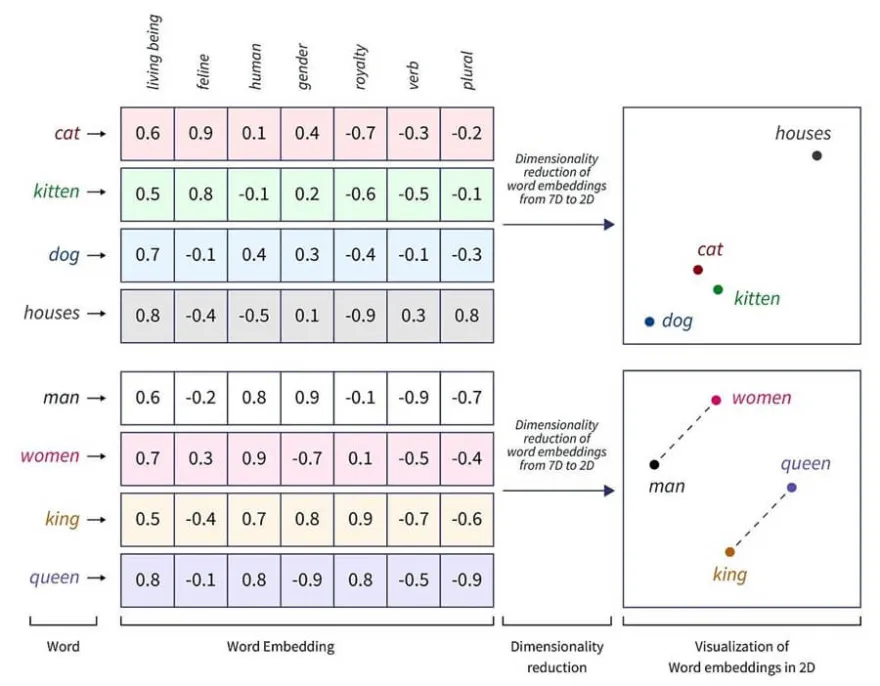

Embedding (wektoryzacja)

Embedding to sposób reprezentacji tekstu w postaci wektorów – ciągów liczb, które umieszczają słowa lub całe frazy w abstrakcyjnej przestrzeni wielowymiarowej.

Jak powiedzieliśmy, modele językowe nie rozumieją dosłownie znaczenia słów ani powiązań między nimi. Dlatego przekształcają je w liczby, które odzwierciedlają ich semantyczne powiązania: słowa o podobnym znaczeniu mają podobne wektory, a ich odległość w przestrzeni wektorowej odzwierciedla stopień podobieństwa. Tak więc wektory słów „kot” i „pies” będą o wiele bliżej siebie niż, powiedzmy, „kot” i „domy”.

Źródło: medium.com/@vipra_singh

Attention i mechanizm „self-attention”

Wróćmy teraz do transformerów. Jednym z powodów, dla których stały się one dominującym typem architektury modeli językowych było zastosowanie tzw. mechanizmu uwagi (attention).

Gdy czytamy tekst, nie zawsze robimy to od deski do deski. Jeśli mamy mało czasu albo jesteśmy czymś rozproszeni, raczej skupiamy uwagę tylko na jego najważniejszych fragmentach. I warstwa attention w modelu językowym działa podobnie – wylicza, które słowa w zdaniu wejściowym są najistotniejsze dla jego znaczenia.

Self-attention jest jeszcze bardziej złożonym mechanizmem, bo porównuje wagę znaczeń wszystkich słów w zdaniu względem siebie nawzajem. Po co? Po to, aby zrozumieć kontekst każdego słowa.

Weźmy na przykład zdanie „Mały kot wskoczył na stół”. Gdy transformer modelu będzie analizować słowo „wskoczył”, przypisze największą wagę słowom „kot” (żeby wiedzieć, kto wskoczył) oraz „stół” (żeby wiedzieć, gdzie wskoczył). Słowo „mały” nie będzie miało w relacji ze „wskoczył” większego znaczenia – ale w kontekście słowa „kot” już tak. I w ten sposób model analizuje całe zdanie.

Inference (wnioskowanie)

Inference – co można przetłumaczyć właśnie jako „wnioskowanie” – to proces, w którym wytrenowany już model wykorzystuje wzorce z danych treningowych oraz wypracowane wagi statystyczne do przewidywania nowych informacji i podejmowania decyzji.

Dostosowywanie modeli i sterowanie wyjściami

Skoro wstęp mamy za sobą – przejdźmy do tego, jak kształtować zachowania modeli AI.

Prompt engineering – jak pisać skuteczne prompty?

Z technik prompt engineeringu korzystasz być może – świadomie lub nie – za każdym razem, gdy rozmawiasz z modelami językowymi. Jest to po prostu projektowanie promptów w taki sposób, aby uzyskać jak najbardziej precyzyjną, spójną i przydatną dla Ciebie odpowiedź.

Ogólna zasada co do modeli AI jest taka: im więcej informacji dostaną „na wejściu” i im lepszej będą jakości, tym większa szansa, że output też będzie lepszy. Dlatego dobrze skonstruowany prompt powinien określać przynajmniej:

- kontekst zadania – cel, zakres, ton odpowiedzi;

- strukturę oczekiwanej odpowiedzi – czy ma to być tabela, lista, cały artykuł na bloga albo wpis na FB;

- ograniczenia – czego ma unikać, jakie dane ma uwzględnić, a jakich nie.

Fine-tuning i techniki PEFT

Fine-tuning obejmuje już nieco bardziej zaawansowane techniki. W skrócie jest to trenowanie wyuczonego już wcześniej modelu na nowym, starannie wyselekcjonowanym zbiorze danych po to, aby dostosować go np. do wymagań konkretnej branży. Taki model zachowuje swoją „wiedzę ogólną”, ale dokłada do niej nowe dane i jest w stanie dostroić się do konkretnego tonu i stylu formułowania odpowiedzi.

Problem polega na tym, że w przypadku największych modeli fine-tuning wymaga ogromnej mocy obliczeniowej, aby „przećwiczyć” wszystkie jego parametry. Dlatego też najczęściej stosuje się lżejsze metody PEFT - Parameter-Efficient Fine-Tuning. Pozwalają one dostroić model bez modyfikowania wag statystycznych wyuczonych podczas treningu. Zamiast tego dodaje się do nich tylko niewielkie warstwy parametrów, które potrafią zupełnie zmienić generowane przez model odpowiedzi… ale wymagają przetrenowania tylko ułamka pierwotnych parametrów (co da się zrobić na zwykłym, choć high-endowym komputerze). Na tej zasadzie działają techniki LoRA oraz QLoRA.

Prompt tuning / prompt injection

Prompt tuning także zalicza się do metod PEFT, choć działa nieco inaczej. Polega na dostrajaniu modelu językowego poprzez uczenie go, jak reagować na określony typ zapytań. Zamiast zmieniać parametry modelu (jak w klasycznym fine-tuningu), modelowi dodaje się niewielki zestaw wyuczonych promptów – specjalnych wektorów. Wektory te są potem „doklejane” do ręcznie wpisywanych promptów i pomagają modelowi lepiej rozumieć kontekst konkretnego zadania.

Natomiast prompt injection to pojęcie z zupełnie innej kategorii, bo dotyczy manipulacji modelem i jego mechanizmami bezpieczeństwa. W skrócie chodzi o umieszczenie w promptcie takiego polecenia, które zmusi go do działania niezgodnego z intencją twórcy – na przykład do ujawnienia danych, z których korzysta model.

Rozszerzanie modeli o wiedzę – RAG i hybrydy

„Wiedza” modeli AI zaczyna się i kończy na danych treningowych. Jak więc sprawić, aby LLM zaczął udzielać odpowiedzi w oparciu o – powiedzmy – dane finansowe Twojej firmy albo raporty z rozmów z klientami? Zobacz, co to jest RAG.

RAG (Retrieval-Augmented Generation) – idea, komponenty, jak to działa

Retrieval-Augmented Generation to technika, która pozwala zintegrować istniejący model ze zbiorem danych z zewnątrz. Jest ona dosyć złożona, dlatego wyjaśnimy, jak działa krok po kroku:

- Zbiór danych (mogą to być dokumenty, raporty, PDF-y, teksty z internetu itd.) zamieniany jest na liczbowe wektory – ponownie pojawia się embedding. Powstaje w ten sposób wektorowa baza danych; można wykorzystać do tego gotowe systemy, np. Milvus czy Pinecone.

- Gdy użytkownik wpisze prompt, system automatycznie przeszukuje bazę, aby znaleźć fragmenty tekstu (a właściwie wektory) najlepiej pasujące do pytania użytkownika – to właśnie retrieval.

- Znalezione fragmenty są dołączane do promptu użytkownika jako kontekst dla modelu językowego – prompt jest nimi „wzbogacony”, stąd słowo augmented.

- Model językowy generuje (generation) odpowiedź, uwzględniając dostarczony kontekst.

Cała architektura RAG opiera się więc na tym, że między promptem a wygenerowaniem odpowiedzi przez LLM pojawia się jeszcze jeden etap – przeszukiwanie bazy danych i wyciąganie z niej tych informacji, które pasują „wektorowo” do promptu.

Porównanie RAG vs fine-tuning – kiedy co stosować?

RAG oraz fine-tuning mają w teorii ten sam cel, ale to duże uproszczenie.

Fine-tuning pozwala modelowi trwale przyswoić wiedzę z określonej dziedziny, dostosować sposób formułowania odpowiedzi lub styl języka. I jak najbardziej się to sprawdza, gdy chcesz rozwijać model pod kątem konkretnego stylu odpowiedzi, nauczyć go technicznego żargonu albo jakiegoś bardzo specyficznego, względnie stałego obszaru wiedzy, np. w medycynie.

Retrieval-Augmented Generation działa inaczej, bo nie zmienia parametrów modelu, tylko rozszerza jego kontekst o konkretne informacje. RAG sprawdza się więc najlepiej, jeśli zależy Ci, aby model korzystał z aktualnych, często zmieniających się danych – na przykład, aby chatbot w dziale supportu mógł wyciągać informacje z firmowej bazy wiedzy, w której znajdują się instrukcje dla wszystkich produktów marki. Albo żeby analitycy finansowi mogli wspierać się modelem, który ma dostęp do najnowszych danych z rynku, a nie tylko tych historycznych.

Hybrydowe podejścia (fine-tuning + RAG)

Największe firmy, które szkolą LLMy na własne potrzeby niemal zawsze korzystają z obu metod.

W takiej hybrydowej architekturze model najpierw się dostraja na specjalistycznym zbiorze danych, aby zdobył podstawową wiedzę z danej dziedziny i przyjął odpowiedni sposób formułowania odpowiedzi (fine-tuning). A dopiero potem buduje się stale aktualizowaną bazę danych oraz warstwę RAG, która będzie wyciągać z niej nowe informacje.

Pozostałe pojęcia warte uwagi

Halucynacje (hallucinations)

O halucynacjach mówimy, gdy model językowy z pełnym przekonaniem generuje odpowiedzi, które brzmią wiarygodnie, ale są niezgodne z rzeczywistością.

Wynikają one z samej natury modeli predykcyjnych. Modele AI nie potrafią rozróżniać, co jest prawdą, a co nie. Jedyne, co robią, to przewidują najbardziej prawdopodobną sekwencję tokenów na podstawie danych treningowych. Dlatego właśnie w pracy z LLMami trzeba zawsze weryfikować informacje, liczby, źródła czy cytaty, które proponuje AI.

Overfitting, underfitting

Overfitting i underfitting opisują dwa klasyczne problemy w uczeniu maszynowym.

Overfitting to sytuacja, w której model zbyt dokładnie zapamiętuje dane treningowe, zamiast uczyć się uogólnień. W efekcie osiąga wysoką skuteczność na danych, które już widział, ale słabo radzi sobie z przeniesieniem wyuczonych schematów na nowe przykłady lub generowaniem odpowiedzi w warunkach braku danych.

Underfitting to z kolei odwrotna sytuacja: model ma zbyt małą bazę danych lub jest zbyt krótko trenowany, przez co nie potrafi wychwycić bardziej złożonych zależności i potem generuje ogólne, niezbyt trafne wyniki.

RLHF (Reinforcement Learning from Human Feedback)

RLFH jest rozwinięciem treningu modeli AI, w którym nieco większą rolę odgrywa człowiek. Polega na tym, że model generuje różne warianty odpowiedzi na dany prompt, a „trener” je ocenia i wybiera najlepszą z nich. I na tej podstawie model uczy się, jakie odpowiedzi są preferowane.

Agent / AI Agents / Multi-agent systems

O agentach AI ostatnio mówi się wszędzie. W dużym skrócie są to programy, które nie tylko potrafią analizować dane i generować odpowiedzi na podstawie promptu, ale też są w stanie samodzielnie podejmować decyzje i wykonywać zadania bez instrukcji „krok po kroku” od człowieka.

Przykładem takiego agenta mógłby być asystent customer service w e-sklepie, który nie tylko rozmawia z klientami (jak zwykły chatbot), ale też sam podejmuje decyzje, kiedy przekazać rozmowę specjaliście, a nawet potrafi wykonać za niego proste zadania: zgłosić reklamację, anulować zamówienie albo zmienić hasło do konta.

Inny przykład, bardziej namacalny? Autonomiczne pojazdy, które są wręcz systemami multi-agent – bo inny model odpowiada w nich za analizę otoczenia, inny za planowanie trasy, a jeszcze inny kontroluje reakcje na zdarzenia drogowe w czasie rzeczywistym.

Zastosowania w marketingu, contentcie i automatyzacji

Jak te wszystkie techniki mają się do marketingu? Praktycznie każda z nich ma tu swoje zastosowanie.

Tworzenie tekstów, rewriting, generowanie pomysłów

Dla copywriterów i content marketerów LLMy są dziś chyba najważniejszym narzędziem pracy. I wygenerują draft artykułu na blog, i zaproponują plan postów na social media, i zajmą się nagłówkami oraz meta danymi pod SEO – w zasadzie na każdym etapie tworzenia treści można się wesprzeć modelem językowym.

Kwestia tylko tego… czy umiesz z niego korzystać – dlatego warto poznać przynajmniej podstawy prompt engineeringu.

Chatboty z bazą wiedzy

Jeżeli – powiedzmy – chcesz wdrożyć w firmie chatbota, który odciąży dział customer service lub który będzie wirtualnym asystentem dla pracowników, korzystanie w tym celu z „ogólnego” modelu językowego raczej mija się z celem. Bo skąd komercyjny LLM ma mieć dostęp np. do firmowych dokumentów albo do specyfikacji technicznej produktów w Twojej ofercie? Nie ma go – dlatego standardem przy wdrożeniach modeli językowych in-house staje się powoli ich integracja z wewnętrznymi bazami wiedzy, zgodnie z architekturą RAG.

Wyszukiwanie semantyczne i rekomendacje

Wyjaśniliśmy wcześniej, czym jest embedding. Zamiana treści na liczbowe wektory pozwala pokazać językiem matematyki, jak zbliżone do siebie znaczeniowo są różne frazy, idee, koncepcje itd.

I właśnie na tym mechanizmie opiera się dziś w dużej mierze… algorytm wyszukiwarki Google, który przecież od dawna nie bazuje już tylko na wpisywanych 1:1 słowach kluczowych, ale potrafi interpretować wyszukiwania według znaczeń i intencji. Wektoryzację można też potencjalnie wykorzystać w systemach rekomendacji – w e-commerce to póki co rzadkość, ale już np. algorytm Netflixa korzysta z niej od dłuższego czasu.

Analiza sentymentu, klasyfikacja, segmentacja

Trening sieci neuronowych sprowadza się tak naprawdę do jednego: do analizy danych w celu wykrycia korelacji między nimi. To właśnie jest samo sedno modeli AI.

Dlatego też najbardziej naturalnym ich zastosowaniem (w marketingu i nie tylko) są narzędzia analityczne, które wychwytują wzorce w danych:

- klasyfikują treści i frazy kluczowe według intencji użytkownika;

- rozpoznają ton wypowiedzi w komentarzach czy postach w social media i w ten sposób mierzą sentyment do marki;

- oceniają nastroje klientów na podstawie rozmów z chatbotem z działu obsługi.

Z takimi zadaniami – jeśli oczywiście mówimy o bardzo dobrze wytrenowanym modelu – sztuczna inteligencja radzi sobie dzisiaj najlepiej.

Porównawcza tabela pojęć

Terminologia wokół AI może przytłaczać, dlatego, bez wchodzenia w techniczne szczegóły, zebraliśmy najważniejsze informacje dla marketerów w poniższej tabelce.

| Pojęcie | Jakie ma znaczenie? | Na co trzeba uważać? |

|---|---|---|

| LLM (Large Language Model) | „Mózg” generatywnych narzędzi AI – napisze outline artykułu, zaproponuje pomysły na kampanię, streści w kilka chwil 100 stron branżowego raportu. | Korzysta tylko z danych, które poznał w trakcie treningu i może halucynować – każdą informację trzeba weryfikować zgodnie z własną, ekspercką wiedzą. |

| Prompt engineering | Jedna z najważniejszych kompetencji dla każdego, kto pracuje z modelami AI. Dobrze napisany prompt = lepsza odpowiedź przy mniejszym wysiłku. | Modele AI, aby generować naprawdę użyteczne odpowiedzi, potrzebują jak najwięcej kontekstu w promptach. |

| Fine-tuning | Metoda dostrajania już wytrenowanego modelu pod Twoje wymagania, na przykład pod styl typowy dla branży i grupy docelowej, z którą pracujesz. | Jest wymagająca technicznie i kosztowna; większość firm rozwijająca swoje customowe modele korzysta z uproszczonych technik, np. LoRA. |

| RAG (Retrieval-Augmented Generation) | Najlepszy sposób na to, by model mógł przy generowaniu odpowiedzi korzystać z firmowych dokumentów, raportów i najnowszych danych. | Wymaga przygotowania tzw. wektorowej bazy danych i regularnych aktualizacji. |

| Agenty AI | Kolejny, duży krok w stronę automatyzacji – bo potrafią na podstawie danych samodzielnie wykonywać działania, na przykład korzystać z innych programów. | Tylko w teorii nie wymagają nadzoru człowieka – aby faktycznie spełniały swoją funkcję, muszą być precyzyjnie zaprogramowane. |

Ciekawostki i trendy

A na koniec naszego słownika pojęć AI, kilka faktów z polskiego podwórka.

- Okazuje się, że bardzo trudno określić, jak chętnie polskie firmy korzystają ze wsparcia sztucznej inteligencji. Według danych Eurostatu z początku 2025 r. AI w codziennych zadaniach wdrożyło tylko… 5,9% firm (co daje przedostatnie miejsce w UE!), a z kolei w raporcie Power of AI od BUZZcenter przeczytamy, że jest to już 22%. Ale oba zgadzają się w jednym – rośniemy, i to bardzo szybko.

- Częściej używamy AI… w celach prywatnych (co, według badania Deloitte, deklaruje 56% Polaków) niż zawodowych (tylko 18%).

- Jeśli na co dzień korzystasz z ChatGPT, Gemini albo Claude – warto porównać, jak spisują się polskie LLMy, wytrenowane w większości na zbiorach danych w rodzimym języku. Na dziś mamy dwie ciekawe opcje, obie open-source’owe: BIELIKa, który pracuje na 11 mld parametrów oraz PLLuM, rozwijany przez Ministerstwo Cyfryzacji, Politechnikę Wrocławską, NASK oraz ekspertów z kilku innych ośrodków badawczych. Ten drugi w swojej najmocniejszej wersji dysponuje 70 mld parametrów i – zgodnie z planami ministerstwa – ma zostać już niedługo wdrożony jako wirtualny asystent w mObywatelu.

- Badacze z Uniwersytetu Maryland oraz Microsoftu wykazali, że największe modele językowe (GPT, Gemini, LLamA, Quen i DeepSeek) najlepiej uczą się i interpretują prompty… w języku polskim! Dlaczego? W badaniu autorzy wskazują, że choć polski jest jednym z trudniejszych języków do nauki dla człowieka ze względu na bogatą fleksję i elastyczną strukturę zdań, dla LLMów mogą być one wręcz zaletą.

Pytania i odpowiedzi

Czy muszę znać matematykę, żeby rozumieć AI?

Absolutnie nie. Do pracy z modelami AI – zwłaszcza w marketingu – wystarczy, że zrozumiesz ogólną zasadę działania oraz (to ważne!) poznasz ich ograniczenia. O wektorach czy fine-tuningu warto wiedzieć, ale w praktyce to obszar raczej dla inżynierów.

Czym różni się LLM od klasycznych chatbotów?

Czy RAG poprawia dokładność odpowiedzi AI?

Pozostałe źródła:

https://mitsloanedtech.mit.edu/ai/basics/glossary/

https://post.parliament.uk/artificial-intelligence-ai-glossary/

https://www.gov.pl/web/cyfryzacja/polska-buduje-wlasna-sztuczna-inteligencje--pllum-gotowy-do-dzialania

Zapisz się do darmowego newslettera

Zyskaj dodatkową wiedzę o SEO, marketingu i technologiach.