Mogłoby się wydawać, że ChatGPT czy Gemini mają niemal nieograniczone możliwości przetwarzania danych. Problem w tym, że nie potrafią czytać w myślach. Współpraca z AI pod jednym względem nie różni się od pracy z drugim człowiekiem – komunikacja jest kluczowa. Jeśli chcesz otrzymywać satysfakcjonujące odpowiedzi, musisz odpowiednio formułować pytania. Jak pisać prompty, aby model językowy spełniał Twoje oczekiwania? Zebraliśmy w jednym miejscu najważniejsze techniki.

Czego dowiesz się z artykułu?

- Co to jest inżynieria promptów i dlaczego zmieni twoją pracę?

- Anatomia idealnego promptu

- Zobacz różnicę w praktyce: prompty „przed i po"

- 5 fundamentalnych technik pisania promptów, które musisz znać

- Najczęstsze błędy początkujących i jak ich unikać

- ChatGPT, Gemini, Claude – czy model ma znaczenie?

- Najczęściej zadawane pytania

Co to jest inżynieria promptów i dlaczego zmieni twoją pracę?

Prompty do AI to wszystkie komunikaty, które przekazujesz modelowi – polecenia, pytania czy instrukcje.

Inżynieria promptów, czyli sztuka zadawania pytań

Inżynieria promptów (prompt engineering) to projektowanie instrukcji dla modeli językowych w taki sposób, aby udzielały jak najprecyzyjniejszych odpowiedzi. Uniwersalna zasada: im więcej danych zawartych w promptcie, tym lepiej dopasowany wynik zgodny z Twoimi potrzebami.

Wyobraź sobie, że zatrudniasz nowego, niesamowicie zdolnego pracownika, który nie zna jeszcze środowiska Twojej firmy i nie do końca „czuje”, jakie są Twoje priorytety i sposób pracy. AI jest właśnie takim pracownikiem – może wykonać niemal każde zadanie, ale tylko wtedy, gdy zna dokładne oczekiwania.

Anatomia idealnego promptu

Prompt engineering odchodzi trochę od tego, co poniekąd obiecują twórcy konwersacyjnych LLMów – że wystarczy wpisać jedno-dwa zdania, a model wygeneruje wszystko, czego oczekujesz, bo dysponuje przecież tak dużym zbiorem danych i niemal nieskończonymi możliwościami ich przetwarzania. To tak nie działa.

Idealny prompt musi być nasycony kontekstem, ponieważ możesz w ten sposób (przynajmniej w pewnym stopniu) kierować pracą modelu. LLMy często nazywa się „czarnymi skrzynkami”, dlatego że operacje na danych są tak złożone, że nie da się ich ani jednoznacznie opisać, ani tym bardziej kontrolować. Jedyne, na co masz wpływ, to właśnie kształt promptu.

-

Rola (persona): nadaj AI tożsamość eksperta

Być może najprostszym sposobem na uzyskanie lepszych odpowiedzi jest nadanie AI persony, czyli konkretnej roli. Jeśli zdefiniujesz „postać”, w jaką ma się wcielić model w trakcie realizacji zadania, dopasuje do niej swój styl i perspektywę.

-

Kontekst: daj AI tło i wszystkie niezbędne informacje

Zanim przedstawisz AI zadanie do wykonania, warto wprowadzić jego kontekst, włącznie z tymi najbardziej oczywistymi (ale tylko dla Ciebie!) informacjami. Jeśli mowa o zastosowaniach biznesowych, to w promptcie warto opisać przynajmniej:

- Twoją sytuację biznesową;

- cele, które chcesz osiągnąć;

- ograniczenia, z jakimi się mierzysz;

- grupę docelową;

- branżę i specyfikę Twojej działalności.

-

Zadanie: określ precyzyjnie, co jest do zrobienia

Dopiero teraz dochodzimy do najważniejszej części promptu. Dobry opis zadania to nie „Pomóż mi z planem postów na social media” albo „Wygeneruj słowa kluczowe dla sklepu sportowego”, tylko raczej:

Zaproponuj plan 8 postów blogowych dla sklepu internetowego z obuwiem sportowym. Każdy post powinien odpowiadać na jedno, konkretne pytanie potencjalnych klientów. Do każdej propozycji dodaj sugerowany tytuł, główną frazę kluczową, 2-3 frazy wspierające oraz krótkie streszczenie (2-3 zdania), które pokaże kierunek treści.

Skup się na tym, aby opisać rezultat, którego oczekujesz – im dokładniej, tym lepiej.

-

Kroki: podziel złożone zadania na etapy

Oczywiście, możesz przedstawić całe zadanie jako jeden, rozbudowany task. W przypadku bardziej złożonych promptów polecamy jednak rozbijać je na mniejsze etapy. Modele AI z reguły lepiej radzą sobie w pracy krok po kroku, z sekwencjami prostszych zadań niż z wielopoziomowymi instrukcjami.

-

Format: wskaż, jak ma wyglądać odpowiedź

Forma odpowiedzi też ma znaczenie. Jeśli sam nie określisz, czego oczekujesz – AI zdecyduje za Ciebie, czy wygeneruje ją w formie bloku tekstu, listy punktowanej czy tabeli. Nie będziesz też mieć kontroli nad długością i strukturą odpowiedzi. To ważne, bo określając oczekiwaną objętość tekstu, możesz wpłynąć na to, z jaką głębią model przeanalizuje temat.

-

Ograniczenia: czego AI ma unikać?

Gdy narzucisz już ograniczenia co do struktury, warto od razu określić, czego konkretnie model ma unikać w treści. Powiedzmy:

Nie używaj technicznego żargonu – tekst musi być zrozumiały dla osób bez doświadczenia w IT.

Stawiając AI jasne granice, zyskujesz o wiele większą kontrolę nad wyglądem odpowiedzi.

-

Przykłady: pokaż AI, czego oczekujesz

Dobry prompt to jedno, ale – naszym zdaniem – najlepszą praktyką jest po prostu przedstawienie modelowi przykładu oczekiwanego wyniku.

Jeżeli pracujesz nad tekstem na bloga albo opisami produktów do sklepu, wyślij razem z promptem kilka tekstów, na których AI ma się wzorować. Jeśli potrzebujesz pomocy przy analizie konkurencji, możesz załączyć podobny raport sprzed roku-dwóch jako punkt odniesienia.

Zobacz różnicę w praktyce: prompty „przed i po"

Spróbujmy w takim razie zamienić dwa proste prompty na lepsze, zgodnie z naszą anatomią.

Przykład 1: copywriting dla e-commerce

Najprostszy prompt mógłby wyglądać tak: Napisz opis produktu dla butów do biegania Nike Air Zoom Pegasus.

A gdy zastosujemy do niego zasady inżynierii promptów?

Jesteś copywriterem specjalizującym się w e-commerce sportowym. Napisz opis produktu dla butów do biegania Nike Air Zoom Pegasus, targetując ofertę do amatorskich biegaczy (10-50 km tygodniowo) szukających uniwersalnych butów na asfalt.

Twój klient ma 25-45 lat, biega rekreacyjnie 3-4 razy w tygodniu, szuka butów do 600 zł. Główna konkurencja to Adidas Ultraboost i ASICS Gel-Nimbus.

Styl powinien być przyjazny, przystępny. Zawsze używaj konkretów zamiast ogólników. Idealna długość opisu to ok. 200-250 słów. Unikaj superlatywów (najlepsze, rewolucyjne, itd), żargonu technicznego, bezpośrednich porównań z konkurencją. Nie stosuj list punktowanych.

W załączniku znajdziesz specyfikację techniczną od producenta butów ze wszystkimi informacjami.

Przykład 2: analiza słów kluczowych pod SEO

Zamiast polecenia typu Znajdź słowa kluczowe dla mojej strony o zdrowym odżywianiu, o wiele lepsze efekty uzyskasz z promptem w stylu:

Jesteś specjalistą SEO z 7-letnim doświadczeniem w branży health & wellness. Przeprowadź strategiczną analizę słów kluczowych dla nowego bloga o żywności funkcjonalnym, prowadzonego przez dyplomowanego dietetyka, który promuje swoje usługi.

Kontekst biznesowy wygląda tak:

- grupa docelowa: kobiety 35-50 lat z problemami hormonalnymi (PCOS, menopauza, tarczyca);

- model monetyzacji: konsultacje online (300 zł/h), e-booki (99-299 zł);

- nowa domena: 0 autorytetu, budujemy jej pozycję od zera.

Cel analizy: znaleźć 50 fraz kluczowych z potencjałem na rankowanie w TOP 10 już w pierwszym roku działania.

Przeprowadź szczegółową analizę w następujących krokach:

- Zidentyfikuj 5 głównych kategorii tematycznych (z uzasadnieniem wyboru).

- Dla każdej kategorii znajdź 10 fraz spełniających kryteria: wolumen 100-2000/miesiąc, KD max 30, intencja informacyjna lub komercyjna.

- Przeanalizuj top 3 konkurentów pod kątem luk w treści – jakie tematy pomijają?

- Wskaż 15 fraz „quick win" (najłatwiejsze do rankowania w 3-6 miesięcy).

- Zaproponuj 10 fraz long-tail z wysokim potencjałem konwersji na konsultacje.

Dla każdej frazy określ:

- szacowany miesięczny wolumen w Polsce;

- Keyword Difficulty (1-100);

- typ intencji (informacyjna/komercyjna/transakcyjna);

- potencjał biznesowy (wysoki/średni/niski);

- idealny format treści (wpis blogowy/landing page/poradnik).

Docelowy format: tabela Excel z filtrami.

W załączniku znajdziesz wyeksportowany raport z Ahrefs (Keyword Explorer) z listą 2,5 tysięcy fraz kluczowych związanych z tematyką bloga. Opieraj się wyłącznie na danych z tego raportu.

5 fundamentalnych technik pisania promptów, które musisz znać

Omówiliśmy, jak zbudować naprawdę skuteczne polecenie dla AI… ale to dopiero początek.

Technika 1: zero-shot vs. few-shot prompting

Jeśli nie podasz modelowi językowemu żadnego punktu odniesienia, jak powinna wyglądać odpowiedź, zdasz się tylko na jego ogólną „wiedzę”. I to jest zero-shot prompting.

Few-shot prompting jest o wiele skuteczniejszy. Polega na pokazaniu AI kilku przykładów wzorowych odpowiedzi, a dopiero potem zadaniu mu polecenia.

Tak więc prompt zero-shot wyglądałby tak: Zaproponuj pięć propozycji subject line (tematów wiadomości) dla kampanii email marketingowej promującej webinar o zastosowaniu AI w HR.

A few-shot?

Oto przykłady dobrze napisanych tematów wiadomości dla webinarów B2B:

- Jak Allegro zwiększyło efektywność rekrutacji o 40% dzięki AI

- 15-minutowe demo: zobacz AI w akcji podczas prawdziwej rozmowy kwalifikacyjnej

- Webinar dla HR: 3 narzędzia AI, które wdrożysz jeszcze w tym kwartale

Przygotuj pięć podobnych tematów dla webinaru „Rewolucja AI w human resources. Jak wykorzystać sztuczną inteligencję w rekrutacji?”, skierowanego do dyrektorów HR w firmach zatrudniających 200+ pracowników.

Technika 2: chain of thought

Kolejna ciekawa (i bardzo prosta) technika – poproś w promptcie wprost, aby model AI wyjaśnił, krok po kroku, jak wygląda proces rozumowania podczas generowania odpowiedzi. LLMy „zmuszone” do analizy własnego toku myślowego automatycznie dzielą problem na mniejsze kroki, przez co do każdego podchodzą z większą precyzją… i popełniają mniej błędów logicznych.

Technika 3: iteracja i doprecyzowanie

Co, jeśli pierwszy prompt nie da Ci takiego efektu, jakiego oczekujesz? Paradoksalnie, to nie musi być problem – na bazie nieudanej odpowiedzi możesz łatwo wskazać modelowi, czego ma unikać przy kolejnych próbach.

Gdy nie będziesz zadowolony z rezultatu pracy AI, w kolejnej wiadomości:

- oceń wygenerowaną odpowiedź – powiedz, co nie spełnia Twoich oczekiwań, a gdzie model spisał się dobrze i co warto utrzymać przy kolejnych próbach;

- porównaj rezultat z oryginalnym promptem – czy AI nie pominęło albo nie przywiązało odpowiednio dużej wagi do którejś z części instrukcji? Jeśli tak, podkreśl to jeszcze raz. Możesz też spróbować wyrazić dany fragment innymi słowami;

- nałóż dodatkowe ograniczenia – wymień konkretnie, na podstawie wcześniejszej odpowiedzi AI, czego model ma nie robić.

Technika 4: „Act as..."

O wcielaniu się w rolę już wspominaliśmy przy okazji inżynierii promptów. Jednak warto się jeszcze zatrzymać przy tym temacie, bo nadawanie persony AI może być o wiele bardziej złożone. Ogranicza Cię tylko wyobraźnia – im więcej szczegółów na temat postaci podasz, tym lepiej.

Załóżmy, że chcesz przygotować poradnik do Pythona dla początkujących (albo sam chcesz opanować jego podstawy). Całą konwersację z AI możesz zacząć od takiego promptu:

Zachowuj się jak developer Pythona z 8-letnim doświadczeniem, który od dłuższego czasu prowadzi po pracy warsztaty dla początkujących programistów. Jest bardzo cierpliwy, w swoim podejściu skupia się na wyjaśnianiu złożonych zagadnień przez analogie, chętnie pracuje na przykładach i wskazuje typowe błędy. Kładzie nacisk na zrozumienie fundamentów języka, nie na sztuczki dla bardziej doświadczonych developerów.

Widzisz? W takim prostym opisie da się pośrednio zawrzeć mnóstwo informacji, np. o stylu pracy lub grupie docelowej.

Technika 5: generowanie zróżnicowanych perspektyw

Jeśli masz za sobą kilka dłuższych rozmów z chatbotami, pewnie zauważyłeś, że miewają tendencję do przytakiwania i skupiania się na informacjach, które – według modelu – są zgodne z Twoimi preferencjami, a nie z faktami. O „problemie pochlebcy”, czyli sycophancy napisano już dużo; polecamy np. świetny tekst Rebecci Bellan z TechCrunch.

Jak to rozwiązać? Są różne sposoby, ale najprostszym jest… poinstruować wprost, aby model zajął się problemem z kilku różnych perspektyw; wtedy z definicji będzie musiał przeanalizować nie tylko „za”, ale też „przeciw”. Powiedzmy, że chcesz porównać koszty biznesowe przejścia na model pracy zdalnej lub hybrydowej w firmie IT. Poproś AI, aby przedstawiło argumenty nie tylko z perspektywy CEO, ale też działu HR, team leaderów oraz zwykłego developera, który zastanawia się nad złożeniem CV w Twojej firmie.

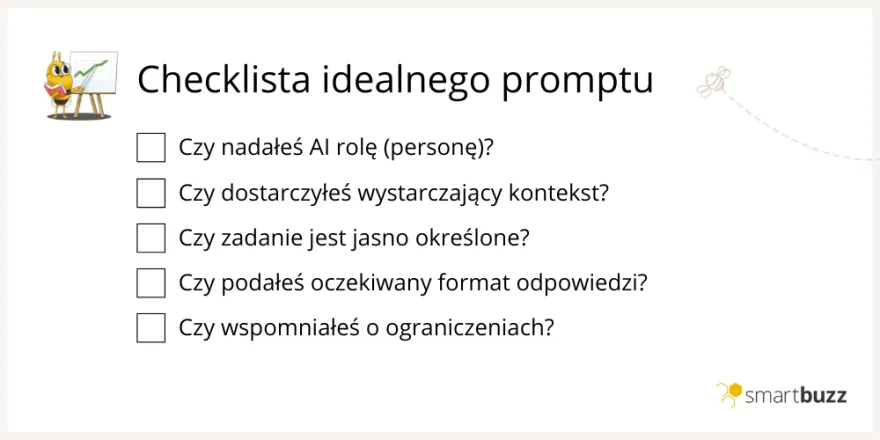

Najczęstsze błędy początkujących i jak ich unikać

Poniżej znajdziesz krótką checklistę z błędami, które na początku pracy z AI pojawiają się najczęściej.

- Brak dokładnego kontekstu zadania – warto mieć świadomość, że na samym początku pracy model jest niczym tabula rasa; nie wie nic o zadaniu, które ma wykonać. Podaj nawet najbardziej oczywiste informacje.

- Niejasne oczekiwania co do formatu – jeśli nie określisz, jak ma wyglądać odpowiedź, model zdecyduje za Ciebie. Przykładowo, zamiast spójnego tekstu na bloga dostaniesz listę punktowaną z suchymi faktami. Dobry prompt musi zawierać konkretne wytyczne co do długości, struktury i stylu generowanej treści.

- Brak ograniczeń – AI nie domyśli się, że czegoś ma unikać. Wyraźnie zaznacz to w instrukcji.

- Zbyt skomplikowane zadania w jednym promptcie – gdy tylko możesz, dziel zadania na etapy i wykonuj je w oddzielnych promptach. Wtedy model przyłoży większą wagę do każdego z nich, a Ty będziesz mógł na bieżąco dodawać sugestie i poprawki.

- Brak przykładów i źródeł – modele językowe uczą się przecież na treściach, prawda? Jeśli chcesz otrzymać wysokiej jakości odpowiedź, podaj wraz ze swoją instrukcją przynajmniej dwie-trzy inspiracje i listę wiarygodnych źródeł informacji, z których może skorzystać.

ChatGPT, Gemini, Claude – czy model ma znaczenie?

Dobra wiadomość jest taka, że podstawy inżynierii promptów są uniwersalne… bo wszystkie popularne modele językowe działają na dokładnie tej samej zasadzie. Owszem, mają różne parametry, szybkość czy głębię przetwarzania informacji i są trenowane na innych zestawach danych, natomiast sposób rozumowania jest identyczny. Tak więc jeśli masz dobrze skonstruowany prompt, to w każdym modelu powinieneś dostać lepszą odpowiedź niż przy użyciu bardziej ogólnikowego polecenia.

Ale tak, same odpowiedzi będą się między sobą różnić… i to diametralnie. Jeżeli dopiero zaczynasz swoją przygodę z LLMami, przetestuj kilka modeli – przygotuj zestaw 4-5 rozbudowanych promptów i zobacz, jak poradzą sobie z nimi różne chatboty. Może się okazać, że np. ChatGPT lepiej zda egzamin z pisania kreatywnych tekstów, a Claude – z zadań wymagających analizy danych. Wtedy możesz wdrożyć oba do swojego workflow… i w obu wykorzystać nasze techniki tworzenia promptów.

Najczęściej zadawane pytania

Czy muszę znać angielski, aby korzystać z narzędzi AI?

Nie – LLMy bez problemu radzą sobie z językiem polskim, tak samo zresztą jak z przekładem obcojęzycznych źródeł.

Angielski bywa jednak przydatny, jeśli będziesz np. szukać gotowych promptów w sieci. Jeżeli znasz język nieco lepiej, warto czasem przetestować te same prompty po polsku i po angielsku, i porównywać wyniki. Modele językowe były trenowane głównie na treściach anglojęzycznych, więc mogą udzielać innych, czasem bardziej pogłębionych odpowiedzi w tym języku.

Czy inżynieria promptów jest trudna?

Czy AI może odmówić wykonania polecenia?

Źródła:

https://cloud.google.com/discover/what-is-prompt-engineering

https://www.ibm.com/think/topics/prompt-engineering-techniques

https://www.promptingguide.ai/

Zapisz się do darmowego newslettera

Zyskaj dodatkową wiedzę o SEO, marketingu i technologiach.