Jednym z powodów, dlaczego modele AI tak chętnie zmyślają fakty jest to, że są trenowane na ograniczonym zbiorze danych – nie mają dostępu do wszystkich tekstów w sieci, do najnowszych artykułów naukowych czy, oczywiście, wewnętrznych dokumentów firm. Ale jest na to rozwiązanie – i kryje się pod skrótem RAG. W tekście poniżej wyjaśnimy, na czym polega ten sposób „wzbogacania” modeli językowych i jak pomaga ograniczyć ryzyko halucynacji AI w marketingu.

Czym jest RAG (Retrieval-Augmented Generation)?

RAG – czyli Retrieval-Augmented Generation – to typ architektury AI, w którym model językowy (jak GPT albo Gemini) jest połączony z zewnętrznym zbiorem danych, aby udzielać odpowiedzi opartych na konkretnych źródłach.

W skrócie: zamiast generować treści wyłącznie na podstawie tego, czego nauczył się podczas treningu, model w architekturze RAG najpierw przeszukuje bazę danych (na przykład z firmowymi dokumentami), wyciąga z niej informacje, które mogą być przydatne i dopiero na ich podstawie formułuje odpowiedź na prompt. To trochę jak różnica między studentem, który odpowiada na egzaminie z pamięci, a tym, który może korzystać z przygotowanych specjalnie na ten egzamin notatek – łatwo się domyślić, który zdobędzie lepszy wynik.

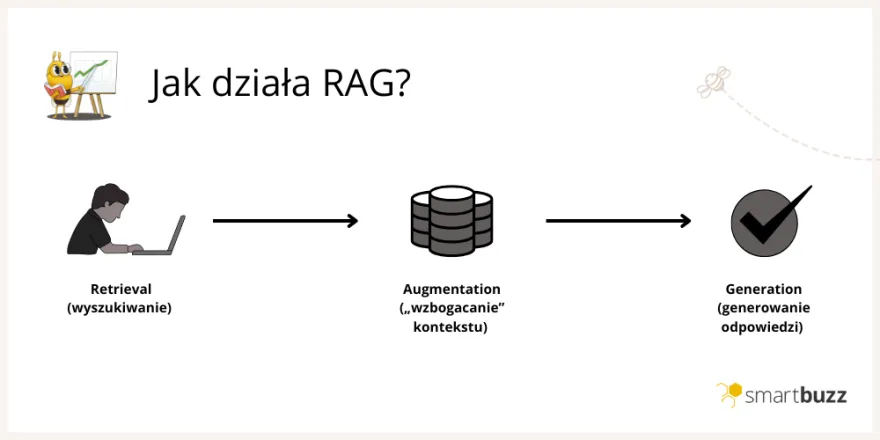

Jak działa RAG w 3 prostych krokach (Retrieval, Augmentation, Generation)

Aby zbudować system RAG, w pierwszej kolejności potrzebna jest baza wiedzy z informacjami, do których model AI ma się odwoływać. Może zawierać dowolne dokumenty: raporty z narzędzi analitycznych czy CRMów, teksty naukowe, do których normalnie LLM miałby ograniczony dostęp, a nawet całe strony internetowe.

Następnie, całą bazę wiedzy przekształca się do postaci wektorowej bazy danych. Każda informacja w bazie ma swoją reprezentację liczbową – wektor. Nie wchodząc głębiej w matematykę, im bardziej zbliżone są do siebie dwa wektory, tym bardziej podobne jest też znaczenie danych, które reprezentują. Właśnie w ten sposób modele językowe interpretują powiązania semantyczne między słowami. Obecnie dostępnych jest przynajmniej kilka dużych narzędzi do tworzenia takich baz wektorowych, m.in. Chroma, Pinecone czy Milvus.

Dopiero gdy masz gotową bazę danych, główny mechanizm może zadziałać:

- Retrieval (wyszukiwanie)

Gdy użytkownik wpisuje prompt, zostaje on zamieniony na wektor, dokładnie tak samo jak informacje z bazy wiedzy. Specjalny algorytm – retriever – przeszukuje potem bazę danych pod kątem wektorów najbardziej zbliżonych do promptu; pod nimi, jak wyjaśniliśmy, powinny kryć się informacje powiązane znaczeniowo z treścią zapytania.

- 2. Augmentation („wzbogacanie” kontekstu)

Retriever porównuje ze sobą dane z bazy i wybiera te, które najbardziej pasują do treści promptu. A następnie, dodaje je do oryginalnego zapytania, jako kontekst. Zaznaczmy – użytkownik tego nie widzi, wszystko dzieje się wewnątrz systemu.

- 3. Generation (generowanie odpowiedzi)

Nowy prompt, wzbogacony o przydatne informacje z bazy, trafia do modelu językowego. Model generuje odpowiedź… z tą różnicą, że odwołuje się w niej bezpośrednio do informacji i źródeł z bazy wiedzy, zamiast korzystać wyłącznie ze swojego własnego, wyuczonego zbioru danych (jak by to wyglądało przy pracy z „czystym” LLMem).

RAG vs fine-tuning (douczanie modelu) – co wybrać?

RAG to tylko jedna z technik personalizacji AI. Inną, o której słyszy się nieco częściej, jest fine-tuning.

Najprościej mówiąc, jest to „douczanie” modelu; przedstawia mu się nowy, starannie przygotowany zbiór danych i pozwala, aby się do niego dostroił. W procesie fine-tuningu oryginalne parametry modelu – wszystkie lub tylko na niektórych warstwach sieci neuronowej, w zależności od zastosowanej techniki – ulegają zmianie, przez co model podejmuje decyzje i generuje odpowiedzi według innych zasad niż w swojej bazowej postaci.

Główna różnica polega więc na tym, że RAG nie zmienia parametrów modelu; modyfikuje jedynie prompty, które do niego trafiają i rozszerza ich kontekst.

Dlatego też fine-tuning i RAG stosuje się w innych celach. Prosty przykład:

Jeśli chciałbyś przygotować – na bazie już istniejącego LLMa – chatbota dla działu customer service w e-sklepie, który przejmie komunikację z klientami i odciąży Twój zespół, to dzięki fine-tuningowi możesz nauczyć go stylu pisania zgodnego z charakterem Twojej marki. A dzięki RAG – będzie mógł wspierać się przy udzielaniu odpowiedzi np. regulaminem zwrotów albo instrukcjami dla wszystkich produktów w ofercie.

Porównanie kosztów i aktualności danych

Przygotowaliśmy jeszcze krótką tabelę, w której powiemy o kilku innych, praktycznych różnicach między RAG a fine-tuningu.

| RAG | Fine-tuning | |

|---|---|---|

| Jakie są koszty wdrożenia? | Niższe – na start największym wydatkiem jest dostęp do oprogramowania do wektorowych baz danych (np. Pinecone) oraz przekształcenie samej bazy wiedzy do postaci wektorowej przy pomocy embedding model (co oferuje m.in. OpenAI). | Zdecydowanie wyższe – aby dostroić model potrzebujesz perfekcyjnie przygotowanych danych treningowych (co często stanowi nawet 40-50% kosztów) oraz sporej mocy obliczeniowej. Jeśli jej nie masz, możesz skorzystać z infrastruktury OpenAI czy Anthropic – ale taka usługa także kosztuje. |

| Jak aktualne są dane, z których korzysta model? | Model korzysta z danych z zewnętrznej bazy, nad którą masz pełną kontrolę i którą możesz aktualizować praktycznie z dnia na dzień. | Model korzysta tylko z danych, na których został wytrenowany – aby je zmienić, trzeba byłoby… jeszcze raz go przetrenować. |

| Czy model potrafi wskazywać źródła danych? | Tak – model jest w stanie wskazać konkretne dokumenty, z których korzystał podczas generowania odpowiedzi. | Nie, ponieważ odpowiedzi pochodzą z wewnętrznych parametrów modelu. |

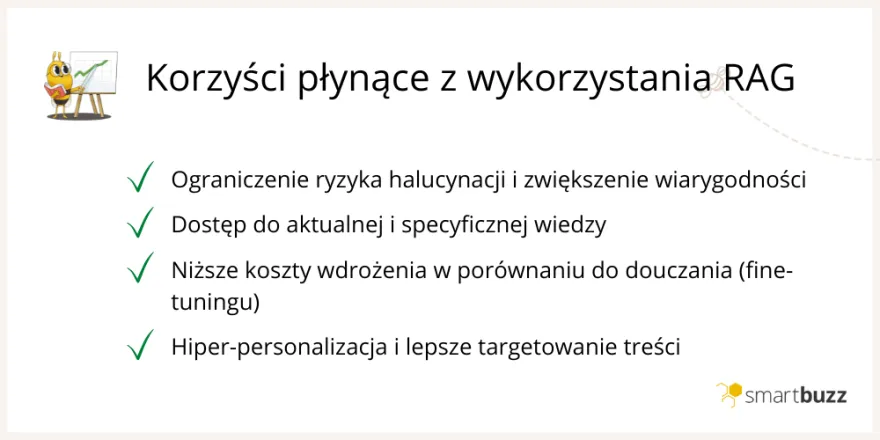

RAG generalnie jest o wiele lepszą techniką, jeśli planujesz wdrożyć model AI oparty na danych własnych firmy i zapewnić mu dodatkową „bibliotekę”, w której będzie mógł znaleźć aktualne informacje lub bardzo specyficzną wiedzę, której nie dałoby się łatwo wyszukać w Google. Ale jeżeli Twoim celem jest zmiana struktury i stylu, w jakim model generuje odpowiedzi na prompty i zaadaptowanie go do bardzo konkretnych zadań (np. tworzenia raportów) – wtedy właściwym wyborem byłby fine-tuning.

Natomiast jeśli chcesz zaadaptować model językowy do jakiegoś konkretnego zadania – powiedzmy, do generowania raportów z CRMu – i narzucić mu inną strukturę oraz styl pracy niż w swojej „bazowej” wersji, trzeba już będzie zainwestować w jego fine-tuning.

Zastosowania RAG, które zmieniają marketing i SEO

Wiesz już, co to jest RAG – pozostaje pytanie, jak taki system można wykorzystać w praktyce.

-

Hiper-personalizacja treści w czasie rzeczywistym

Wdrożenie AI w firmie często zaczyna się od pomysłu: „niech sztuczna inteligencja pisze dla nas teksty”. To oczywiście nie jest takie proste, ale faktem jest, że modele językowe potrafią mocno skrócić czas pracy np. nad materiałami marketingowymi.

RAG daje jeszcze większe możliwości, bo w takiej architekturze model AI może generować treści na podstawie aktualnych informacji o Twoich odbiorcach.

Wystarczy umieścić w bazie wiedzy raporty z CRM, Google Analytics i innych narzędzi analitycznych; dzięki temu AI powinno być w stanie o wiele lepiej targetować treści. Mamy tu na myśli na przykład landing page’e dopasowane stricte pod konkretne intencje klientów albo personalizowane maile, SMSy i powiadomienia push, pisane w innym stylu pod różne grupy docelowe.

-

Generowanie artykułów eksperckich zgodnych z E-E-A-T

Na podobnej zasadzie możliwa jest optymalizacja procesów contentowych z RAG.

„Czyste” modele językowe generują treści tylko w oparciu o dane ze swojego zbioru treningowego, ewentualnie o to, co znajdą w internecie. Jeśli poprosisz taki model o pomoc przy tworzeniu eksperckiego artykułu na blog – nie spodziewaj się, że dostaniesz od niego unikalne informacje, których czytelnik nie byłby w stanie znaleźć na kilku pierwszych stronach wyników w Google. A to problem, bo algorytmy wyszukiwarki premiują raczej treści z wyraźnym wkładem własnym (zgodnie z E-E-A-T).

Architektura RAG rozwiązuje i ten problem, bo możesz dzięki niej kontrolować, z jakich źródeł będzie korzystać model przy tworzeniu contentu. Jeżeli zbierzesz w bazie wiedzy wyniki badań ze swojej branży, dodasz swoje case studies, white paper’y, dokumentację techniczną, może nawet transkrypcje wywiadów z ekspertami – AI będzie się do nich odwoływać w swoich odpowiedziach.

-

Inteligentne chatboty, które naprawdę znają ofertę (i nie kłamią)

Tradycyjne chatboty do obsługi klienta – te, które funkcjonowały jeszcze przed „erą AI” opierały się na predefiniowanych skryptach. Gdy pytanie klienta było choć trochę bardziej skomplikowane, stery od razu musiał przejąć konsultant.

Modele językowe szybko to zmieniły… ale dopiero dzięki systemom RAG takie chatboty faktycznie pomagają klientom, a nie ich irytują.

Bot, który wspiera się zewnętrzną bazą danych, wie dokładnie: co jest dostępne w magazynie, jakie są ceny, jakie promocje obowiązują, jak działają zwroty w sklepie. A jeśli ma naprawdę rozbudowaną bazę, może nawet porównywać oferty i doradzać klientom w zakupach albo pomagać rozwiązywać problemy z produktami na bazie ich instrukcji. Chyba najlepszym przykładem takiego chatbota jest Rufus od Amazon, który już dziś działa jak pełnoprawny asystent zakupowy.

Przyszłość RAG – w kierunku AIO i AI Mode

Z AI opartego na RAG korzystasz – nawet jeśli o tym nie wiesz – za każdym razem, gdy wpisujesz pytanie w wyszukiwarce.

Zarówno AI Overviews, jak i wprowadzony niedawno AI Mode, czyli konwersacyjny tryb wyszukiwarki Google, działają na bardzo podobnym schemacie. Nie czerpią swojej wiedzy wyłącznie ze swojej „wyuczonej” bazy danych, tylko przytaczają ją ze stron indeksowanych w Google. Czyli można powiedzieć, że dla Gemini (modelu, na którym pracują obie te funkcje) zewnętrzną bazę wiedzy stanowi… cały indeks Google.

I to pokazuje, że RAG jest przyszłością rozwoju AI. Choć to dosyć prosta architektura, pozwala zapewnić modelom językowym dostęp do wszystkich informacji, których potrzebują, aby ograniczyć halucynacje – czyli ogromny problem, z którym cały czas borykają się wszystkie LLMy.

FAQ – najczęstsze pytania o RAG w biznesie

Czy moje dane są bezpieczne w RAG?

Tak, ponieważ to Ty masz pełną kontrolę nad bazą danych i nad tym, jakie informacje w niej umieścisz. AI będzie korzystać wyłącznie z nich – nie musi mieć dostępu np. do danych wrażliwych Twoich klientów.

Ile kosztuje wdrożenie RAG?

Zapisz się do darmowego newslettera

Zyskaj dodatkową wiedzę o SEO, marketingu i technologiach.